1.服务器虚拟化 服务器虚拟化将系统虚拟化技术应用于服务器上,将一个服务器虚拟成若干个服务器使用。 在采用服务器虚拟化之前,三种不同的应用分别运行在三个独立的物理服务器上;在采用服务器虚拟化之后,这三种应用运行在三个独立的虚拟服务器上,而这三个虚拟服务器可以被一个物理服务器托管。 简单来说,服务器虚拟化使得在单一物理服务器上可以运行多个虚拟服务器。 服务器虚拟化为虚拟服务器提供了能够支持其运行的硬件资源抽象,包括虚拟BIOS、虚拟处理器、虚拟内存、虚拟设备与I/O,并为虚拟机提供了良好的隔离性和安全性。

2.典型实现 服务器虚拟化通过虚拟化软件向上提供对硬件设备的抽象和对虚拟服务器的管理。 目前,业界在描述这样的软件时通常使用两个专用术语,它们分别如下。 (1)虚拟机监视器(Virtual MachineMonitor,VMM):虚拟机监视器负责对虚拟机提供硬件资源抽象,为客户操作系统提供运行环境。 (2)虚拟化平台(Hypervisor)虚拟化平台负责虚拟机的托管和管理。它直接运行在硬件之上,因此其实现直接受底层体系结构的约束。

原生虚拟化:在原生虚拟化中,直接运行在硬件之上的不是宿主操作系统,而是虚拟化平台。虚拟机运行在虚拟化平台上,虚拟化平台提供指令集和设备接口,以提供对虚拟机的支持。这种实现方式通常具有较好的性能,但是实现起来更为复杂,典型的实现有CitrixXen、VMware ESX Server和Microsoft Hyper-V。 3.关键特性 (1)多实例。通过服务器虚拟化,在一个物理服务器上可以运行多个虚拟服务器,即可以支持多个客户操作系统。服务器虚拟化将服务器的逻辑整合到虚拟机中,而物理系统的资源,如处理器、内存、硬盘和网络等,是以可控方式分配给虚拟机的。 (2)隔离性。在多实例的服务器虚拟化中,一个虚拟机与其他虚拟机完全隔离。通过隔离机制,即便其中的一个或几个虚拟机崩溃,其他虚拟机也不会受到影响,虚拟机之间也不会泄露数据。如果多个虚拟机内的进程或者应用程序之间想相互访问,只能通过所配置的网络进行通信,就如同采用虚拟化之前的几个独立的物理服务器一样。 (3)封装性。也即硬件无关性,在采用了服务器虚拟化后,一个完整的虚拟机环境对外表现为一个单一的实体(例如一个虚拟机文件、一个逻辑分区),这样的实体非常便于在不同的硬件间备份、移动和复制等。同时,服务器虚拟化将物理机的硬件封装为标准化的虚拟硬件设备,提供给虚拟机内的操作系统和应用程序,保证了虚拟机的兼容性。 (4)高性能。与直接在物理机上运行的系统相比,虚拟机与硬件之间多了一个虚拟化抽象层。虚拟化抽象层通过虚拟机监视器或者虚拟化平台来实现,并会产生一定的开销。这些开销即为服务器虚拟化的性能损耗。服务器虚拟化的高性能是指虚拟机监视器的开销要被控制在可承受的范围之内。

|

《虚拟化与云计算》阅读笔记 从虚拟化到云计算

更多阅读

《最后一头战象》读书笔记 最后一头战象读书小报

《最后一头战象》读书笔记 在我们学完《最后一头战象》这篇课文后,我找来沈石溪作家的同名小说《最后一头战象》,进行了阅读,感觉很有意思。这本书分三大部分,第一部分写的是象,第二部分写的是猪,在这部分里,讲了三个故事,分别是《野猪跳板

《为权利而斗争》读书笔记 异端的权利 读书报告

《为权利而斗争》读书笔记陈朝勇一、阅读文本简介书名:《为权利而斗争》耶林:[德] 鲁道夫.冯.耶林(Rudolfvon Ihering) 译者:胡宝海出版:中国法制出版社 2004年11月第1版书号:ISBN 7-80182-386-9/D.1352

本·阿格尔《西方马克思主义概论》读书笔记(一) 中国化马克思主义概论

本·阿格尔《西方马克思主义概论》读书笔记本·阿格尔及其代表作《西方马克思主义概论》在生态学马克思主义学术史上具有极为重要的位置,因为“生态学马克思主义”这个概念首先是本·阿格尔在《西方马克思主义概论》中提出的,自此一

韩国经典剧情电影《肚脐与膝盖之间》中字完整版 肚脐与膝盖之间完整版

韩国经典剧情电影《肚脐与膝盖之间》[中字完整版]在朝鲜时代,三个人谁也不相信爱情,于是决定打个赌。损坏的亲情故事开始了!最好的朋友张,韩元,崔珉和他的妻子殷慧打个赌,以打发他们的无聊生活。然而,赌走错路,他们真的了解什么爱吗?...

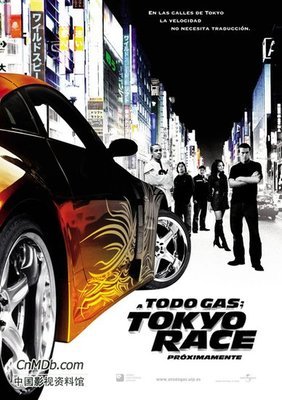

《速度与激情3》简介 速度与激情5简介

电影介绍:《速度与激情3》本片将日本山道上“飘移超车”出神入化的震撼绝技作为了表现的重点。台湾裔导演林诣彬大胆启用全新阵容,“嘻哈小天王”宝娃所饰的主人公是一名在美国惹麻烦、为避免身陷囹圄而不得不躲到日本的热血少年,在当

爱华网

爱华网